Der brasilianische Fußballstar Vinicíus Júnior, Deutschlands schnellster Sprinter Owen Ansah, die deutsche Biathletin Vanessa Voigt – sie alle erlebten in sozialen Medien schon eine Welle von Hasskommentaren. „Man liest immer wieder von Athletinnen und Athleten, die sich auf Social Media mit schlimmsten Anfeindungen und Beschimpfungen konfrontiert sehen“, sagt auch Thomas Weikert, Präsident des Deutschen Olympischen Sportbundes (DOSB). „Das wollen wir nicht länger dulden.“ Zu den Olympischen Spielen und den Paralympics hat der DOSB seinen Athletinnen und Athleten einen Hate-Speech-Filter angeboten, der Hasskommentare in Echtzeit erkennt und blockiert. Die Kommentare werden gespeichert, um sie in justiziablen Fällen an Strafverfolgungsbehörden weiterzugeben.

Laut einer Studie der Landesanstalt für Medien in Nordrhein-Westfalen (LFM NRW) haben mehr als 70 Prozent der Internetnutzerinnen und -nutzer in Deutschland bereits Hasskommentare online gesehen oder selbst erlebt. Die Landesmedienanstalten sind im Rahmen der Medienaufsicht auch für Internet-Dienste und Plattformen zuständig. Seit Jahren setzen sie KI-Tools ein, um Hass und Hetze im Internet aufzuspüren und zu bekämpfen. Früher durchsuchten studentische Hilfskräfte manuell Hunderte Kommentarspalten und Social-Media-Posts nach potenziellen Rechtsverstößen. Die Inhalte reichten von Holocaustleugnung über Volksverhetzung bis zu frei zugänglicher Pornografie. „Das war weder besonders effizient noch mitarbeiterschützend“, sagt die zuständige Referentin Barbara Banczyk. „Es war eine Sisyphus-Arbeit, bei der wir oft unvermittelt mit drastischen Inhalten konfrontiert wurden.“

Um effizienter zu arbeiten und die Mitarbeitenden besser zu schützen, kooperiert die Landesmedienanstalt NRW seit August 2020 mit dem Berliner IT-Unternehmen Condat. Das Ergebnis ist ein Software-Programm namens KIVI, eine Wortschöpfung aus KI und „vigilare“ (lat. „wachsam sein“). Das KI-Werkzeug durchsucht täglich bis zu 10.000 Seiten im Internet – darunter klassische Webseiten und Plattformen wie Telegram, TikTok oder X. Es ist auf potenziell strafbare Texte, Bilder und Videos trainiert, sucht nach Tausenden Stichworten und zeigt die Funde in einem Ticketsystem an. Zum Schutz der Mitarbeiterinnen und Mitarbeiter lässt sich jeder Arbeitsplatz so einstellen, dass explizite Inhalte im Vorschaubild nur unscharf dargestellt werden.

„Die Verstöße lassen sich jetzt priorisieren und entsprechend der Schwere abarbeiten“, sagt Banczyk und beschreibt damit einen weiteren großen Vorteil von KIVI gegenüber der manuellen Recherche. Die Bilanz: Allein die LFM in Nordrhein-Westfalen hat seit dem Start von KIVI im März 2021 bis Anfang Juli 2024 von insgesamt mehr als 43.000 Funden rund 38.300 überprüft und so 8.279 Verstöße bestätigt. „KIVI recherchiert für uns viel breiter nach rechts und links, und unsere Trefferquote hat sich deutlich erhöht“, sagt Banczyk. Die Anzahl der Strafanzeigen an die Staatsanwaltschaft konnte mehr als verdoppelt werden. „Wir sehen KIVI als Unterstützung für Menschen und nicht als Ersatz“, betont Banczyk. Die Verantwortung müsse am Ende beim Menschen liegen. Juristinnen und Juristen der Landesmedienanstalten bewerten die Inhalte final.

Das Modell kam gut an: Seit April 2022 nutzen alle 14 Landesmedienanstalten KIVI und tauschen sich bundesweit über ihre Arbeit aus. KIVI verhindert durch das Ticketsystem, dass alle Landesmedienanstalten dieselben Posts bearbeiten. Das Programm wird fortlaufend optimiert, durch die größeren Datenmengen lernt es stetig dazu. Landesmedienanstalten können die entdeckten Inhalte nicht selbst löschen, sondern melden sie den Plattformen oder bringen sie zur Anzeige. Über eine Schnittstelle können sie ihre Strafanzeigen direkt aus KIVI an die Zentrale Meldestelle für Internetkriminalität beim Bundeskriminalamt (ZMI) senden. Die ZMI leitet die Fälle zur weiteren Strafverfolgung an die zuständigen Landeskriminalämter weiter. Nach Feststellung der Strafbarkeit der Inhalte kümmern sich die Landesmedienanstalten um die medienrechtliche Verfolgung – also um die Aufforderung zur Löschung bei den Plattformen.

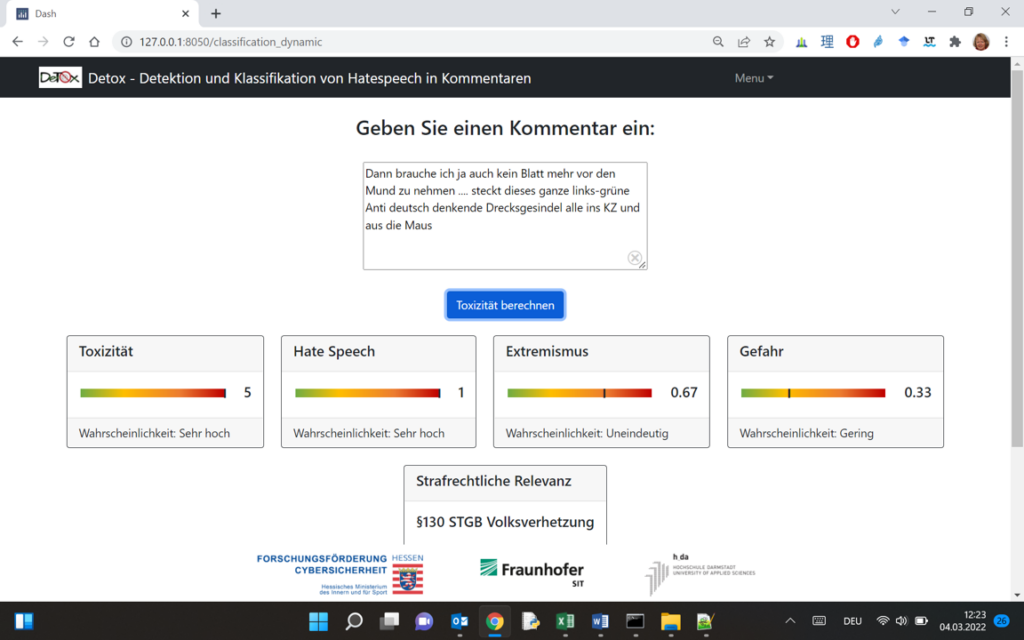

Einen anderen Ansatz verfolgen Forschende der Hochschule Darmstadt, die zwei KI-basierte Softwareprogramme entwickelt und der Meldestelle „Hessen gegen Hetze“ zur Verfügung gestellt haben. DeTox steht für „Detektion für Toxizität“ und BoTox für „Bot- und Kontexterkennung im Umfeld von Hasskommentaren“. „DeTox durchsucht das Netz nicht aktiv selbst, sondern unterstützt die Meldestelle dabei, die von Nutzerinnen und Nutzern eingehenden Meldungen nach strafrechtlicher Relevanz zu sortieren und zu priorisieren“, erklärt Professor Dr. Melanie Siegel (Foto ganz oben), Leiterin des Forschungsprojekts von der Hochschule Darmstadt. BoTox geht noch einen Schritt weiter und erkennt mittlerweile gut, ob ein Mensch die Hasskommentare geschrieben hat oder ein Bot, also ein Roboter.

„Eines unserer größten Probleme ist es, dass sich die Themen mitunter schnell ändern. Im Jahr 2019, aus dem unser großer Datensatz stammt, gab es zum Beispiel noch kein Corona“, sagt Siegel. Das erfordert ein permanentes Nachtrainieren und ständiges Aktualisieren der Daten. Beleidigungen und Schimpfwörter ändern sich ebenfalls. „Man muss immer up to date sein“, so Siegel. Lebenslanges Lernen gilt auch für KI. Die Maschine lernt anhand der Daten, was potenziell strafbarer Inhalt ist und was freie Meinungsäußerung. Diese KI-unterstützten Sprachtechnologien extrahieren aus vorhandenen Daten Merkmale und versuchen so, neue Inhalte danach zu klassifizieren. „Danach muss immer noch ein Mensch draufgucken“, sagt Siegel. „Ich würde die Entscheidung am Ende nie einer Maschine überlassen.“

Die Forschung zu Hasskommentaren kommt nicht überall gut an. Die hessische Landtagsfraktion der AfD wittert in einer Kleinen Anfrage an die Landesregierung eine „ideologische Nutzung von künstlicher Intelligenz an der Hochschule Darmstadt“. Melanie Siegel sagt: „In unserem Forschungsprojekt geht es darum, Strafverfolgungsbehörden dabei zu unterstützen, strafrechtlich relevante Hasspostings schneller erkennen und priorisieren zu können. Das hat nichts mit Ideologie zu tun.“

Der Vorwurf der rechtspopulistischen Partei greift aus Siegels Sicht noch aus einem anderen Grund ins Leere. Die Professorin und ihr Team haben bereits bei der Entwicklung ihrer KI-Programme im Rahmen des Forschungsprojekts viele Hasskommentare zu den unterschiedlichsten Themen im Netz gesammelt, um die KI damit zu trainieren. Es zeigte sich: „Das meiste davon kam aus der rechtsradikalen Ecke.“ Für die Entwicklung der KI-Tools war das ein Problem. „Wenn man so einen unausgewogenen Datensatz hat, erkennt unser Tool Hass von links überhaupt nicht. Also habe ich meine Mitarbeitenden damit beauftragt, gezielt Hate Speech aus der linksextremistischen Ecke zu suchen und mit in unseren Datensatz aufzunehmen. Es war gar nicht so einfach, dies in ausreichender Menge zu finden, aber wir haben es geschafft.“

Melanie Siegel denkt im Rahmen des Forschungsprojekts wissenschaftlich, nicht in politischen Kategorien. „Menschen zu bedrohen, zu diskriminieren oder zu beleidigen hat mit politischer Ausrichtung nichts zu tun, sondern ist in jedem Fall verwerflich, teilweise sogar strafbar“, sagt Siegel. „Mich stört es sehr, dass dieser Hass mittlerweile so normalisiert wird. Das ist eine Tendenz, die mir gesellschaftlich überhaupt nicht behagt.“

Professor Dr. Melanie Siegel und ihr Team suchen weiter nach dem besten digitalen Helfer gegen den Hass im Netz. Jetzt geht es im Forschungsprojekt BoTox bis mindestens Januar 2025 darum, wie sich Hasskommentare über Netzwerke von Personen und Gruppen hinweg fortpflanzen. Und um die zentrale Frage: Wie lässt sich der Hass im Netz stoppen?

Ob der KI-Einsatz während der Olympischen Spiele in Paris Sportlerinnen und Sportler vor Hasskommentaren geschützt hat, ist indes noch unklar. Nach Angaben eines DOSB-Sprechers seien die Daten noch nicht ausgewertet.

Christoph Klemp